Всего два часа назад коллеги с techPowerUP разместили у себя материал по GeForce GTX Titan. С пылу с жару преподношу его пересказ вам, уважаемые читатели. Времени на работу было меньше обычного, потому прошу сильно не пинать за результат.

Всего два часа назад коллеги с techPowerUP разместили у себя материал по GeForce GTX Titan. С пылу с жару преподношу его пересказ вам, уважаемые читатели. Времени на работу было меньше обычного, потому прошу сильно не пинать за результат.

Как это принято в материалах с tPU, обзор начинается со сводной таблички с характеристиками тестируемой видеокарты и некоторых других решений:

| GeForce GTX 580 | Radeon HD 7970 | HD 7970 GHz Ed. | GeForce GTX 680 | GeForce GTX 590 | GeForce GTX Titan | GeForce GTX 690 | |

|---|---|---|---|---|---|---|---|

| Потоковые процессоры | 512 | 2048 | 2048 | 1536 | 2x 512 | 2688 | 2x 1536 |

| ROPы | 48 | 32 | 32 | 32 | 2x 48 | 48 | 2x 32 |

| Графическое ядро | GF110 | Tahiti | Tahiti | GK104 | 2x GF110 | GK110 | 2x GK104 |

| Количество транзисторов | 3000M | 4310M | 4310M | 3500M | 2x 3000M | 7100M | 2x 3500M |

| Объём буфера | 1536 МБ | 3072 МБ | 3072 МБ | 2048 МБ | 2x 1536 МБ | 6144 МБ | 2x 2048 МБ |

| Разрядность шины | 384-бит | 384-бит | 384-бит | 256-бит | 2x 384-бит | 384-бит | 2x 256-бит |

| Частота ядра | 772 МГц | 925 МГц | 1050 МГц | 1006 МГц+ | 607 МГц | 837 МГц+ | 915 МГц+ |

| Частота памяти | 1002 МГц | 1375 МГц | 1500 МГц | 1502 МГц | 855 МГц | 1502 МГц | 1502 МГц |

| Стоимость | $430 | $390 | $400 | $480 | $750 | $1000 | $1000 |

Ценник у карты... ладно - оставим это без комментариев, ТОП он и есть ТОП.

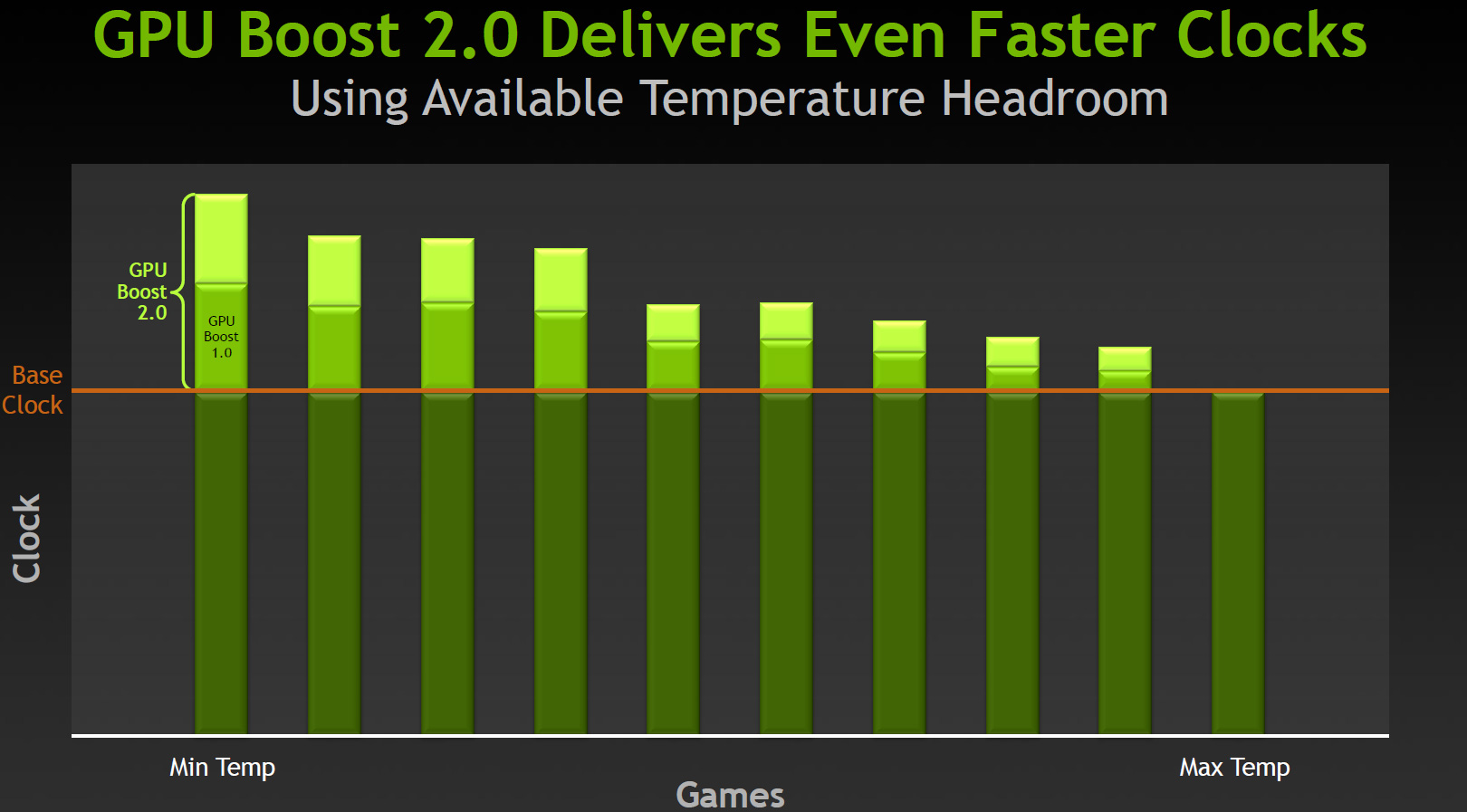

В GTX Titan нам представили новую технологию, вернее - развитие старой. Речь о GPU Boost 2.0:

На графике показано, что новая технология шпарит почище старой, чем наверняка порадует владельцев изделия Nvidia.

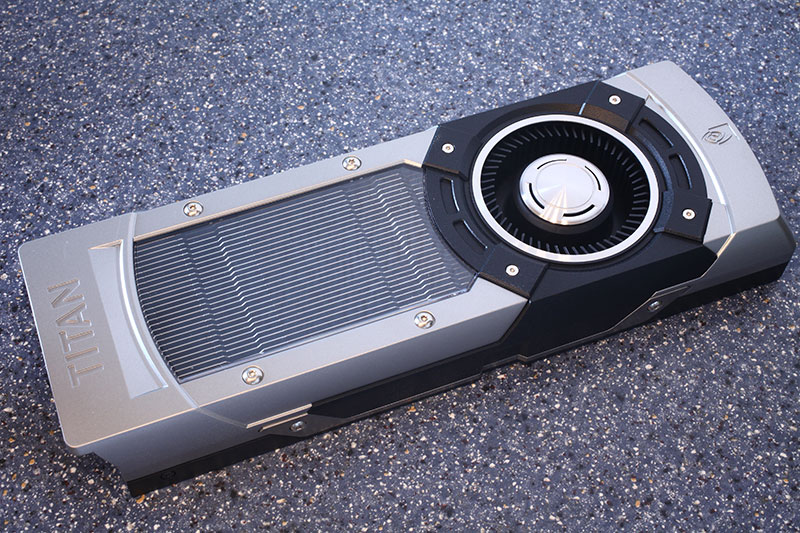

Карточка GTX Titan попала к ревьюверам без упаковки, в OEM виде, так что давайте поглядим на графический адаптер Nvidia GeForce GTX Titan вблизи:

Визуально новинка похожа на GTX 690, только в её дизайне применено всего одно прозрачное окошко, а не два, а вентилятор расположен в правой части изделия, а не посередине.

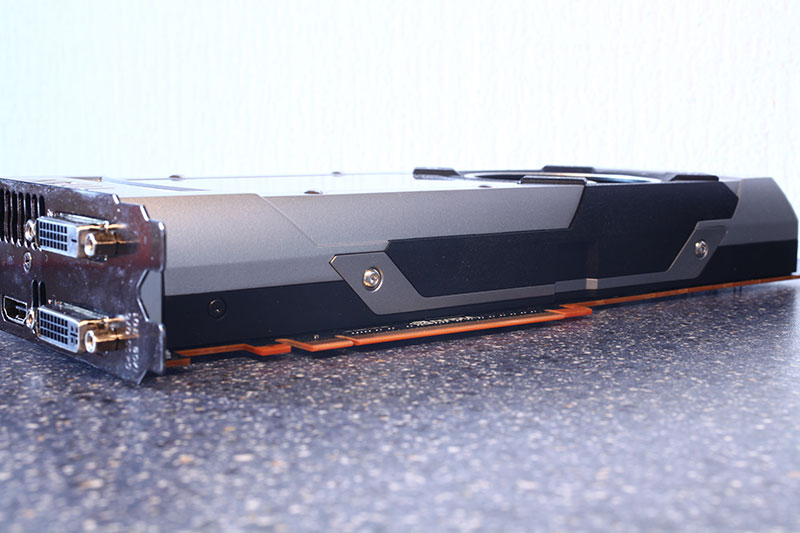

Видеокарта GTX Titan занимает два слота в системном блоке ПК.

Видеовыходы у GeForce GTX Titan имеются следующие: два DVI, один DisplayPort и HDMI.

Коннекторов SLI у карты два, а значит можно объединить в тандем до четырёх GTX Titan. Если деньжат хватит ![]() .

.

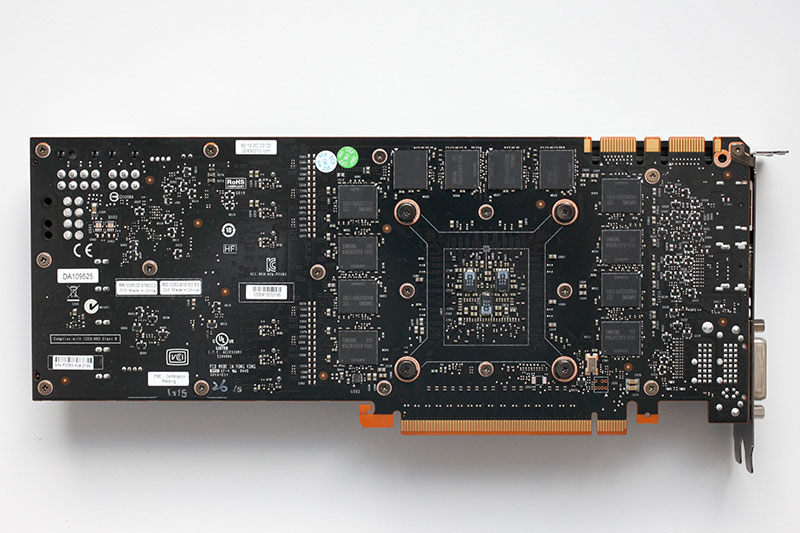

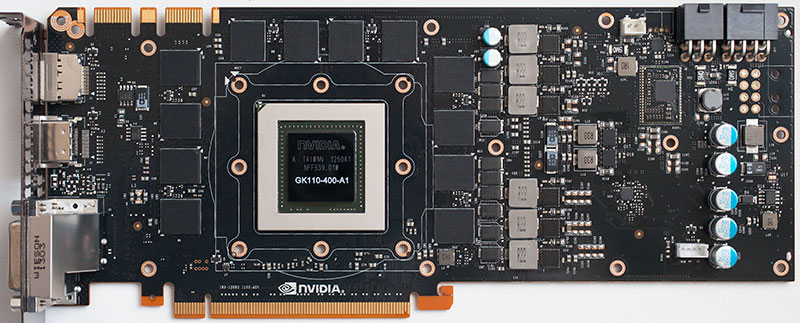

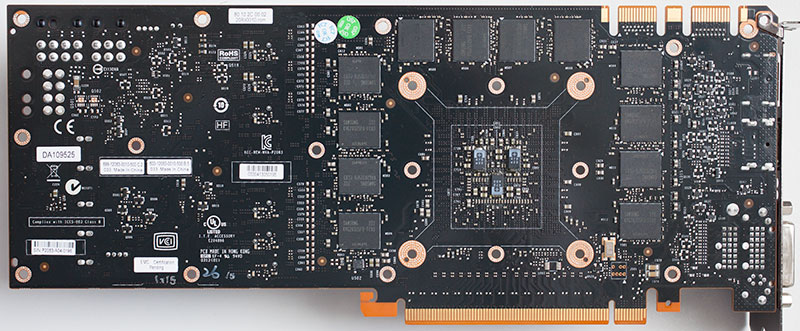

На фото изображена печатная плата GTX Titan, вид спереди и сзади. Как в анекдоте про нового русского в Эрмитаже - "скромненько... но чистенько".

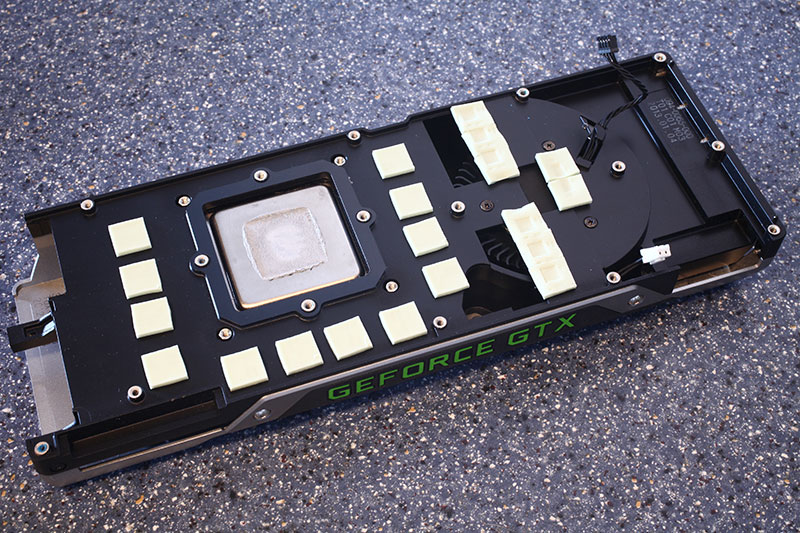

Вот какой кулер используется на творении Nvidia:

Для охлаждения своего дорогого творения Nvidia использовала довольно мудрёный кулер на основе испарительной камеры. Охлаждаются и ядро и память и VRM, жаль в комплекте нет бэкплейта, он бы не помешал.

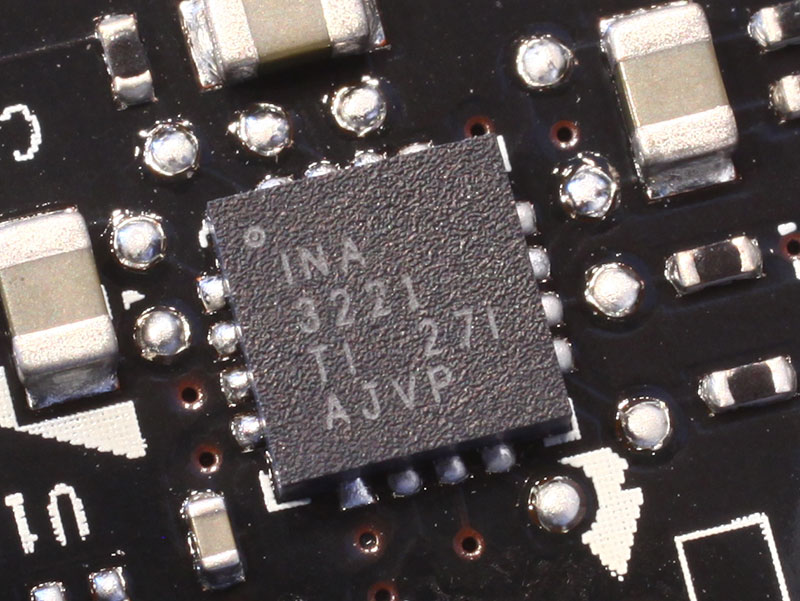

На фото выше показан сенсор Texas Instruments INA 3221, служащий для мониторинга энергопотребления карты в реальном времени. Это замена ранее использовавшимся для тех же целей трём чипам INA219.

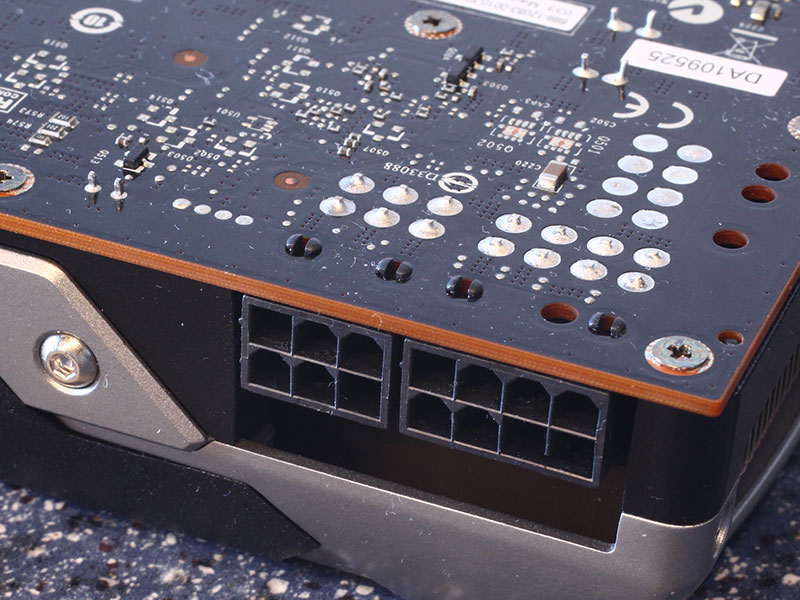

Питание продукта Nvidia осуществляется через связку из 8+6 пиновых коннекторов БП:

На фото показан используемый контроллер напряжения - OnSemi NCP4206, не самое крутое решение, ибо исключает продвинутый мониторинг. У партнёров Nvidia в их вариантах GTX Titan почти наверняка будет использоваться что-то другое.

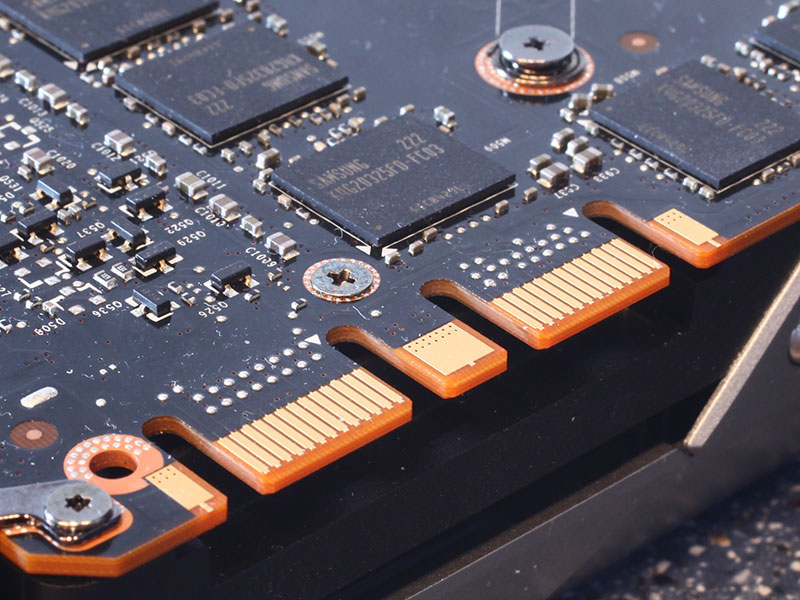

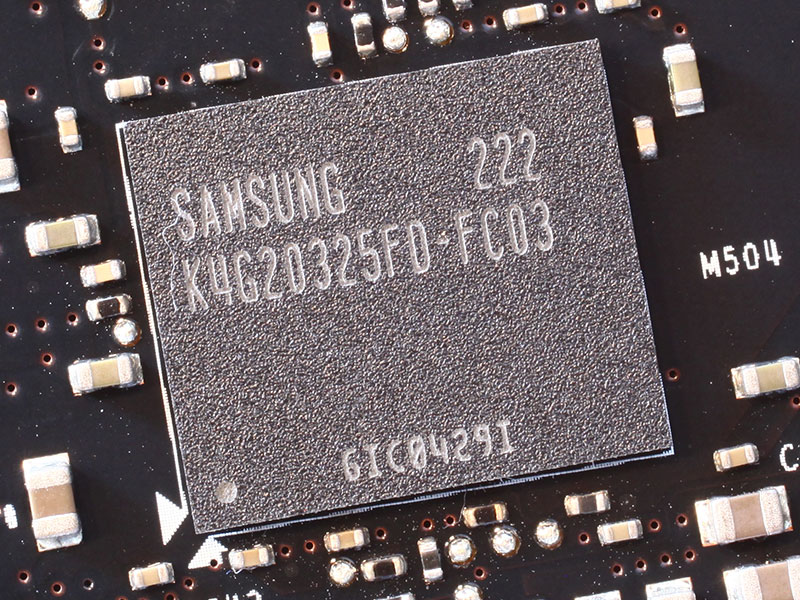

А вот фото чипа памяти:

В данном продукте используется память K4G20325F0-FC03 от Samsung, работать она может на 6000МГц (эффективных).

Перед нами графическое ядро GK110, сделанное по нормам 28нм. тех.процесса на мощностях TSMC (Тайвань). Количество транзисторов - 7.1 миллиарда, площадь - 561мм². Готовим суперкулеры и СВО ![]() ?

?

Конфигурация тестового стенда

| Тестовый стенд | |

|---|---|

| Процессор: | Intel Core i7-3770K @ 4.6 ГГц (Ivy Bridge, 8192КБ кеша) |

| Материнская плата: | ASUS Maximus V Gene Intel Z77 |

| Оперативная память: | 2x 4096МБ Corsair Vengeance PC3-12800 DDR3 @ 1600 МГц 9-9-9-24 |

| Накопитель: | WD Caviar Blue WD5000AAKS 500ГБ |

| Блок питания: | Antec HCP-1200 1200 ватт |

| ОСь: | Windows 7 64-бит SP1 |

| Версии драйверов: | NVIDIA: 310.70 WHQL ATI: Catalyst 13.1 WHQL GTX Titan: 314.09 Beta |

| Монитор: |

LG Flatron W3000H 30" 2560x1600 3x Hanns.G HL225DBB 21.5" 1920x1080 |

Далее говорится, что все бенчмарки были запущены на максимальных настройках графики, при следующих разрешениях и с выставленным определённым образом антиалиасингом:

- 1280 x 1024, 2x АА. Стандартные настройки графики для мониторов с диагональю 17" - 19"

- 1680 x 1050, 4x АА. Стандартные настройки графики для мониторов с диагональю 19" - 22"

- 1920 x 1200, 4x АА. Стандартные настройки графики для мониторов с диагональю 22" - 26"

- 2560 x 1600, 4x АА. Стандартные настройки графики для мониторов с диагональю 30" и выше

- 5760 x 1080, 4x AA. Типичное разрешение в мультимониторной конфигурации.

Игровые тесты

Alan Wake

Давно уже вышедшая на XBOX 360 игра теперь живёт и на ПК. Разумеется, она похорошела и требует неслабого "железа", несмотря на то, что использует DirectX 9.

Batman: Arkham City

Продолжение приключений Тёмного Рыцаря, защитника Готэм-сити. Игра использует модифицированный движок первой части, с DX11 и прочими наворотами, потому очень требовательна к "железу" ПК.

Assassin's Creed 3

Новая игра серии Assassin's Creed, вышедшая в 2012 году. Она использует движок AnvilNext на пару с физикой Havok, до ресурсов ПК игрушка жадна не в пример больше предыдущих представителей серии AC.

Battlefield 3

Уже даже не знаю какая по счёту часть Battlefield, всё жутко красиво и динамично, спасибо новому движку Frostbite 2. DX11 поддерживается в полной мере.

Borderlands 2

Сиквел Borderlands - игра, что использует модифицированный в значительной степени движок Unreal Engine 3 (DX9).

Call of Duty: Black Ops 2

Новая часть CoD, почитать про которую я рекомендую вот в этом материале. Игра использует DX11, но не сказать, чтобы была очень требовательной к ПК.

Crysis

Как только не называли игру от немецкого разработчика - и убийцей видеокарт и уничтожителем процессоров. Да - требования у неё столь серьёзные, что ни одна одиночная видеокарта уже в течении четырёх+ лет (с момента выхода игры в свет) не может на нормальном (60+) FPS её тянуть на максимальных настройках графики.

Crysis 2

Долгожданное продолжение "Крайсиса" использует движок CryEngine 3, однако пока ещё работает лишь в режиме DX9, за что компании-разработчику сильно достаётся от критиков (да и на форумах). К счастью, вскоре был выпущен DX11 патч и набор текстур высокого разрешения, с применением которых и был проведён данный тест. В отличие от первого Crysis, вторая его часть не даёт детально настроить графику, а использует пресеты для этого.

Diablo III

Игра не нуждается в представлении. В данном продукте Blizzard используется DX9 движок, что не мешает DIII в лёгкую класть на лопатки одночиповые ТОПы прошлого поколения даже в Full HD. Тест в Diablo III проходил на максимально доступных настройках графики.

Far Cry 3

Всё, что нужно знать о Far Cry 3, Вы можете прочесть вот здесь. Игра чрезвычайно хороша визуально (используется оптимизированный под DX11 движок Dunia), главное, чтобы "железо" не подвело.

F1 2012

Симулятор гонок F1, игра работает на улучшенном варианте движка Ego 2.0, использует DX11. Для тестов использовались максимальные настройки графики.

Hitman: Absolution

Подробнее об игре читайте тут. Используется DX11 движок Glacier 2, игрушка требовательна к ПК чрезвычайно.

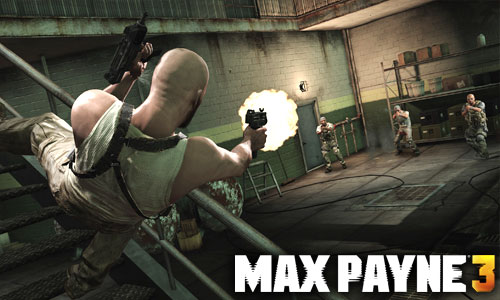

Max Payne 3

Третья игра про приключения Макса Пейна, бывшего полицейского с трагической судьбой. Игра весит немалое количество гигабайт и использует DX11 движок. Настройки для тестов выставлялись максимально возможные.

Metro 2033

Экстремально требовательный к "железу" 3Д-экшн от украинских разработчиков. Поддерживает DirectX11 и тесселяцию. Тесты проводились в режиме DX11, а для карточек, что его не поддерживают - в DX10.

Sleeping Dogs

Довольно красивая игра в стиле GTA, использует DX11 движок, прожорлива до системных ресурсов. Все настройки игры были максимизированы, но super-sampling был выключен.

StarCraft II

Вторая часть знаменитой RTS-ветерана, вышла в июле 2010 года, использует движок на DX9, но выглядит всё равно очень неплохо. Тест проводился методом проигрывания записи матча 1 на 1.

The Elder Scrolls: Skyrim

Очередная игра серии The Elders Scroll, очередной хит. Графика в игре хороша, но не на грани фантастики, однако этот факт не мешает Skyrim быть очень требовательным к ПК.

World of Warcraft: Mists of Pandaria

Самая ужасная игра из всех MMORPG - она вытягивает время и денежки с простодушных игроков и помогает заработать более хитрым и дальновидным. Бессонные ночи, проведённые за ней месяцами напролёт, будут преследовать игроков WoW всю их оставшуюся жизнь ![]() . Игрушка довольно резво бегает на старых ПК при слабых настройках графики, что радовало и радует обладателей ПК многолетней давности. Стоит заметить, что расширение игры Cataclysm привнесло красоты DX11, от чего ветеран (год выпуска оригинального WoW - 2004) заметно похорошел. Дополнение Mists of Pandaria также не ударило в грязь лицом в плане графики. При тестировании были использованы настройки Ultra.

. Игрушка довольно резво бегает на старых ПК при слабых настройках графики, что радовало и радует обладателей ПК многолетней давности. Стоит заметить, что расширение игры Cataclysm привнесло красоты DX11, от чего ветеран (год выпуска оригинального WoW - 2004) заметно похорошел. Дополнение Mists of Pandaria также не ударило в грязь лицом в плане графики. При тестировании были использованы настройки Ultra.

Синтетические тесты

3DMark 11

Долгожданный, но встреченный весьма холодно, бенчмарк от Futuremark. Работает только на DX11-системах, чрезвычайно тормозной/жадный до ресурсов ПК, что Вы увидите по графикам ниже.

Энергопотребление видеокарты GeForce GTX Titan

Как всегда, авторы материала с techPowerUP хорошо постарались, дабы у нас не осталось и тени сомнений по поводу энергопотребления тестируемой видеокарты. Графики весьма наглядны, как и всегда, собственно:

Замеры в режиме простоя проходили, когда на экране монитора был просто рабочий стол Windows Vista Aero (разрешение - 1280x1024, 32-х битный цвет), никаких программ не запущено, окна (в Винде, а не в помещении) закрыты.

Это замер энергопотребления в мультимониторной конфигурации. Режим рабочего стола (Aero включен), никаких окон не открыто, режим дисплея - 1280х1024 при 32-битном цвете.

Тест выше - среднее потребление карты в режиме нагрузки. Использовался Crysis 2, работающий в разрешении 1920x1200, на профиле Extreme. Замер длился только в игровой части бенчмарка, экраны загрузок и прочее не-3Д не учитывались.

Результат на слайде выше - пиковое потребление видяхи в режиме нагрузки. Методика та же - Crysis 2, работающий в разрешении 1920x1200, на профиле Extreme.

Замер максимального энергопотребления проводился с помощью "Волосатого бублика" (Furmark) в режиме Stability Test, настройки были следующими: 1280x1024, 0xAA.

Последний замер проводился, когда запускалась программа Power DVD 9 Ultra и в ней просматривался фильм "Бэтмен: Тёмный рыцарь" в разрешении 1920x1200 (использовался отрезок фильма с битрейтом в 40МБ/с), ускорение декодирования видео силами GPU было включено.

В простое, мультимониторном режиме и во время просмотра Blu-ray энергопотребление называется фантастическим (в хорошем смысле слова). Это крайне приятно, по крайней мере во время обычной работы за ПК карточка электроэнергии скушает мало.

В игровом режиме энергопотребление называется приемлемым, с учётом производительности. Для сравнения - GTX Titan намного быстрее HD 7970 GHz Edition, а потребляет электроэнергии меньше творения AMD. GTX Titan можно называть самый энергоэффективной видеокартой TOP уровня из существующих.

Уровень шума

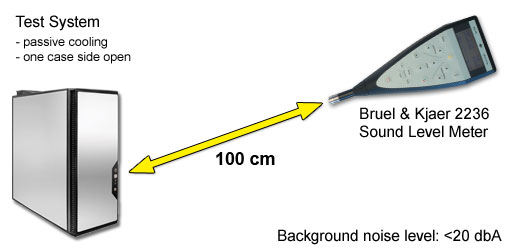

Авторы материала с TPU всегда серьёзно относятся к замерам уровня шума, потому при этой процедуре используют очень дорогой девайс Bruel & Kjaer 2236 (ориентировочная стоимость - $4000):

Замеры производились с расстояния в один метр, все компоненты компьютера охлаждались пассивно и не шумели:

В простое карту попросту неслышно, когда как в нагрузке она выделяется на фоне прочих компонентов ПК. Новый режим GPU Boost 2.0 позволяет, образно выражаясь, выбирать между высокой производительностью и низким уровнем шума, например можно назначить желаемую температуру GPU в 70 градусов по Цельсию, в этом случае карта будет работать на более низких частотах и напряжении, а также более низких оборотах вентилятора. Значение по-умолчанию - 80 градусов.

Отмечается, что ниже 65° температуру понизить не удалось. Впрочем, старые методы регулировки скорости вращения вентилятора видеокарты до сих пор работают, так что кому не охота заморачиваться с настройкой GPU Boost 2.0, те могут использовать MSI Afterburner или иной похожий софт.

Display Overlocking / разгон монитора

Довольно странная и необычная фича, которую Nvidia решила представить вместе с GTX Titan - разгон дисплея.

В чём прикол? В том, чтобы заставить 60Гц монитор показывать изображение с большей частотой развёртки.

Зачем это нужно? Всё просто - чем выше частота монитора, чем больше FPS, тем плавнее становится картинка с включённым Vsync. Слайд выше показывает, что 60Гц монитор удалось заставить работать на 80Гц, а значит с Vsync геймер будет видеть 80FPS, а чем их больше - тем лучше/плавнее.

Реализация Display Overlocking поручена сторонним компаниям, т.е. в драйвер такой функционал не встроен. Автор оригинального материала воспользовался EVGA Precision:

Ему удалось разогнать монитор LG W3000H с 60 до 75Гц, а вот Dell U3011 не давал ставить более 65Гц, ругался он таким образом:

Интересно - получится ли разогнать 120Гц монитор? Мой может работать на 144Гц, возможно и это не предел? Автор оригинального материала дал понять, что на данный момент разгон монитора работает только в Windows и играх, запущенных в окне, т.е. в полноэкранном режиме погамать на 75Гц/75FPS (или ином из количестве, как кому повезёт) пока не удастся. Возможно, что проблема решится в будущих версиях драйверов.

Разгон видеокарты GeForce GTX Titan

Чем разгонялась карточка - не ясно, но напряжение не менялось, да и логику управления вентилятором не трогали. В итоге был достигнут следующий результат: 1005/7020МГц (ядро/память):

Нам сообщили, что карт на тесты были прислано три и все они погнались по-разному, скриншот выше показывает лучший результат из троицы. Ядро погналось на 20%, а память - на 17%. Разгонный потенциал видеокарты довольно высок, наверное многие GTX Titan возьмут 1ГГц предел.

Вот табличка по присланным картам:

| Сравнение разгонного потенциала | ||

|---|---|---|

| Максимальная частота GPU | Максимальная частота памяти | |

| GTX Titan, серийный номер 195 | 990 МГц | 1780 МГц |

| GTX Titan, серийный номер 207 | 1005 МГц | 1730 МГц |

| GTX Titan, серийный номер 235 | 1005 МГц | 1755 МГц |

По табличке ниже можно понять, как сильно оверклокерские манипуляции повлияли на производительность видеокарты Nvidia (на примере игры Battlefield 3):

Рост производительности за счёт разгона составил 21%.

График ниже показывает пропорциональное разгону и поднятию напряжения увеличение температуры графического ядра.

График ниже показывает положение дел при thermal target выставленным на 94 градуса по Цельсию и power limit, выставленный на 106%.

А теперь посмотрим на то, как увеличились температуры у GeForce GTX Titan в разгоне:

Boost Clock 2.0 хорошо заботится о температурах, потому от разгона они не выросли.

GeForce GTX Titan, как и многие другие видеокарты под разными видами нагрузки, выставляет особые частоты и напряжения, вот соответствующая табличка:

| Частота ядра | Частота памяти | Напряжение на GPU (основано на замерах) |

|

| Режим 2D (карта в простое) | 324 МГц | 162 МГц | 0.88 V |

| Мультимониторная конфигурация | 324 МГц | 162 МГц | 0.88 V |

| Воспроизведение Blu-ray | 324 МГц | 162 МГц | 0.88 V |

| Режим 3D (карта в нагрузке) | 836-993 МГц | 1502 МГц | 1.00 - 1.15 V |

График ниже показывает расклад по зависимости частот от напряжения на GPU:

Выводы

Начнём с раздела выводов "за" и "против", как в оригинальном материале.

|

|

|

|

|

|

|

Новая видеокарта GTX Titan раскрывает весь потенциал архитектуры Kepler, по сравнению с GTX 680 новинка на 30% быстрее в разрешении 2560x1600 и на 23% в среднем шустрее в прочих разрешениях. Данный видеоадаптер на деле и предназначен для разрешения не ниже 2560x1600, для остального сгодится то, что уже ~год как выпущено.

Карта на 25% быстрее Radeon HD 7970 GHz Edition, но в половину дороже. Радует, что в отличие от прочих видеокарт на базе Kepler, GeForce GTX Titan не теряет позиций в разрешении 2560x1600, т.е. того падения FPS, как мы видели у GTX 680, в данном случае мы не наблюдаем.

GTX 690, двухчиповый монстр, примерно на 20% быстрее GTX Titan, стоит столько же, но до сих пор страдает от корявости SLI. Впрочем, из богатого набора бенчмарков в данном материале лишь в F1 2012 видеоадаптер GTX 690 отработал не как положено. У AMD дела куда хуже, их CrossFire не оправдал надежд в 6 из 19 приложений.

Внешний вид карты называется крайне приятным, все эти металлические корпуса, плексигласовые стёкла и так далее, очень привлекают определённую часть юзеров. Жаль, что бэкплейта в комплекте нет, так карта выглядела бы лучше, а ощущалась бы ещё дороже.

Технология GPU Boost 2.0 позволяет видяхе работать тихо, уменьшая до заданного предела частоты и напряжение. В простое карта бесшумна, в нагрузке - нет, но всё равно несравнимо тише HD 7970 GHz Edition. Энергопотребление также порадует всякого - для столь производительного решения карточка в нагрузке отнюдь не чудовищно жадна до электроэнергии, ну а в простое так и вовсе имеет скромные аппетиты.

Разгон изделия вовсе неплохой, по мнению ревеьювера, владелец GTX Titan может рассчитывать на 20% прирост частот (и, как ни странно, производительности) без учёта Boost. Да и память гонится отнюдь неплохо.

В данном своём творении Nvidia представила новую "фичу", названную Display Overclocking, её суть в следующем - заставить (к примеру) 60Гц монитор выдавать большее количество Гц, скажем - 75Гц. У ревьювера получилось заставить работать свой монитор на 75Гц, что увеличило плавность картинки при включённом Vsync, однако не факт, что этот результат гарантирован на всех устройствах вывода видеосигнала. Хотя поэксперементировать сможет каждый владелец не 120Гц монитора (наверное и они смогут, но вот толку в этом будет не очень много).

Ценник видеокарты GeForce GTX Titan - слабая сторона продукта Nvidia. За карточку просят 1000 долларов США, ровно столько же, как и за GTX 690, которая несколько быстрее новинки в определённых условиях. GTX 680 и HD 7970 GHz Edition стоят примерно вдвое меньше (даже больше, чем вдвое), учитывая разницу в производительности между ними и GTX Titan лишь в 30%, ценник нового детища Nvidia не выглядит очень разумным. Конечно, Nvidia идёт в плюс тот факт, что именно из под её пера вышла самая быстрая видеокарта в мире, однако явно завышенный ценник изделия не делает чести компании и наверняка отпугнёт тех, кто не прочь владеть такой картой, но... скажем за $700.

Оценка видеокарты GeForce GTX Titan: 9 из 10.

Награда (с присуждением которой у ревьювера возникли определённые трудности):

Выбор редактора

p.s. Обязательно посмотрите Армаду по GeForce GTX Titan, она постоянно пополняется новыми видеокартами этого семейства.

Автор оригинальной статьи - W1zzard, "перевод" - Slayer Moon, эксклюзивно для www.u-sm.ru

Статья является вольным переводом, даже скорее, пересказом обзора устройства с сайта techPowerUP, она не нарушает ничьих прав, ибо все права принадлежат их авторам, а фотографии к статье - фотографам с указанных выше Интернет-ресурсов

Если Вы заметите ошибки, помарки и прочее - дайте мне знать: Ctrl+Enter (Орфус).

Понравился материал "У SM"?

}

| < Три Titan'а под окном пряли поздно вечерком. Тест GeForce GTX Titan в 3-Way SLI | Обзор бюджетного корпуса Xigmatek Asgard Pro > |

|---|